大多數Databricks客戶使用生產版Databribeplay体育app下载地址cks運行時發行版(AWS|Azure|GCP)。但是,在拋出支持票據後,有時可能會要求您運行自定義Databricks運行時。

本文將介紹如何在獲得support提供的運行時映像名稱後,使用自定義Databricks運行時映像啟動集群。

指令

使用工作區UI

按照特定瀏覽器的步驟添加自定義Spark版本字段到新的集群菜單。

啟用自定義Spark版本字段,您可以使用它來啟動一個新的集群,使用支持提供的自定義Databricks運行時映像。

Chrome / Edge

- 登錄到Databricks工作區。

- 點擊計算。

- 點擊通用的集群。

- 點擊創建集群。

- 按Command+Option+J (Mac)或Control+Shift+J (Windows, Linux, ChromeOS)打開Javascript控製台。

- 輸入window.prefs.set(“enableCustomSparkVersions”,真的)在Javascript控製台中運行該命令。

- 重新加載頁麵。

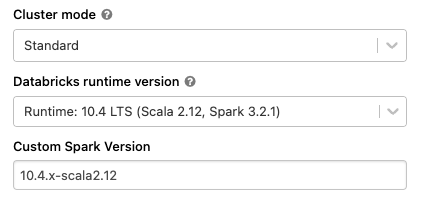

- 自定義Spark版本現在出現在新建集群菜單中。

- 中的Databricks支持中獲取的自定義Databricks運行時映像名稱自定義Spark版本字段。

- 繼續像往常一樣創建集群。

火狐

- 登錄到Databricks工作區。

- 點擊計算。

- 點擊通用的集群。

- 點擊創建集群。

- 按Command+Option+K (Mac)或Control+Shift+K (Windows, Linux)打開Javascript控製台。

- 輸入window.prefs.set(“enableCustomSparkVersions”,真的)在Javascript控製台中運行該命令。

- 重新加載頁麵。

- 自定義Spark版本現在出現在新建集群菜單中。

- 中的Databricks支持中獲取的自定義Databricks運行時映像名稱自定義Spark版本字段。

- 繼續像往常一樣創建集群。

Safari

- 登錄到Databricks工作區。

- 點擊計算。

- 點擊通用的集群。

- 點擊創建集群。

- 按Command+Option+C (Mac)打開Javascript控製台。

- 輸入window.prefs.set(“enableCustomSparkVersions”,真的)在Javascript控製台中運行該命令。

- 重新加載頁麵。

- 自定義Spark版本現在出現在新建集群菜單中。

- 中的Databricks支持中獲取的自定義Databricks運行時映像名稱自定義Spark版本字段。

- 繼續像往常一樣創建集群。

使用API

方法設置自定義映像spark_version屬性,當通過API啟動集群時。

您可以使用API使用自定義Databricks運行時映像創建交互式集群和作業集群。

“spark_version”:“自定義:< custom-runtime-version-name >

示例代碼

這個示例代碼顯示了spark_version在通過API啟動集群上下文中使用的屬性。

%sh curl -H "Authorization: holder" -X POST https:// /api/2.0/clusters/create -d '{"cluster_name": "heap", "spark_version": "custom: ", "node_type_id": "r3. xml " . sh curl -H "Authorization: holder " -X POST https:// /api/2.0/clusters/create -d 'Xlarge ", "spark_conf": {"spark. conf"。投機":true}, "aws_attributes": {"availability": "SPOT", "zone_id": "us- west2a "}, "num_workers": 1, "spark_env_vars": {"SPARK_DRIVER_MEMORY": "25g"}}'